本文共 878 字,大约阅读时间需要 2 分钟。

背景

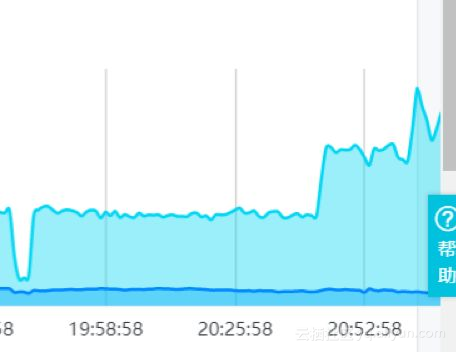

2018年2月24日晚,卓见云某客户网站公网出流量突然爆发性增长,导致带宽被占满,事故发现后紧急提升了SLB的带宽,但提升后的带宽仍然被流量占满(原带宽15M,提升至35M)。由于事故发生在非黄金访问时段,正常流量不会这么大,加上其他现象,怀疑是遭到了网络攻击。

WAF流量

经历

21:19 接到用户电话,反馈事故发生

21:20 引导用户通过临时切换SLB来更换IP的方式进行紧急事故处理,但当时用户暂不方便操作

21:22 引导用户提交工单

21:23 汇报我方领导,通知我方工程师上线处理

21:25引导用户进行故障排除,查看DDoS安全报表,发现并无DDoS攻击

21:30进一步排查发现入流量并无明显增加,根据客户网站特点和运维经验判断可能是被爬虫暴力抓数据造成

21:43 排查发现主要是客户移动站点流量异常

21:51 查看WAF安全报表发现大量业务爬虫、robots脚本访问告警

21:55 建议用户通过WAF精准访问功能封禁爬虫IP

22:10 筛选IP

22:23 封禁IP,问题解决

Web应用防火墙数据

Web应用防火墙精准访问控制

分析

1、商业对手,出于竞争需要,采用爬虫获取信息。

2、搜素引擎抽风。

3、“三月份爬虫”,应届毕业生为交论文常在这个时间点在网上爬取数据,此类爬虫通常简单粗暴,不管服务器压力。

4、近期做的推广活动带来访问压力增加。

建议

1、建立反爬虫手段,后台对IP、session、userAgent进行统计,超过阈值,予以封锁。进一步也可以通过cookie校验、验证码限制等手段。建议多种手段组合使用,达到封锁和误杀之间的平衡。PS:当前直接封IP的方式只是临时解决方案,因为IP是很容易更换的。

2、利用云监控,在SLB和WAF上建立告警规则。建立告警事件处理预案机制。

3、当前WAF版本较低,精准访问控制只支持基于IP和URL的封禁,不支持user-agent和cookie字段,建议把WAF版本升级成企业版。或者开通按量付费WAF,开通精准访问控制高级功能,可临时解决问题。

转载地址:http://lugox.baihongyu.com/